O novo modelo VaultGemma 1B é o maior treinado inteiramente com privacidade diferencial, sacrificando o desempenho de ponta para garantir zero vazamento de dados, segundo o Marktechpost.

O Google AI Research e a DeepMind anunciaram o lançamento do VaultGemma 1B, um modelo de linguagem de grande porte (LLM) que redefine o equilíbrio entre capacidade e segurança. Conforme detalhado pelo portal Marktechpost, este é o maior modelo de peso aberto (1 bilhão de parâmetros) treinado inteiramente com Privacidade Diferencial (DP), uma abordagem que garante matematicamente a proteção dos dados de treinamento.

A iniciativa do Google aborda um dos problemas mais críticos da IA generativa: a memorização e o vazamento de informações sensíveis. Diferente de outras abordagens que aplicam privacidade apenas no ajuste fino, o VaultGemma 1B integrou essa proteção desde o pré-treinamento, estabelecendo um novo precedente para o desenvolvimento de IA que seja inerentemente segura, ainda que, como os testes mostram, isso signifique um desempenho inferior aos modelos não privados atuais.

Por que a privacidade diferencial é crucial em LLMs?

Grandes modelos de linguagem, treinados em trilhões de tokens da internet, têm uma tendência preocupante de “memorizar” dados. Como aponta o Marktechpost, isso significa que informações sensíveis, incluindo dados pessoais identificáveis (PII), podem ser extraídas do modelo através de “ataques de memorização“. Estudos já comprovaram que dados de treinamento literais podem ressurgir, um risco enorme para a privacidade do usuário e para a conformidade regulatória das empresas que os utilizam.

-

Fim da era das Smart Tv’s: Projetor 4K que gira 360° chega ao Brasil e promete transformar qualquer parede em cinema de luxo com imagem a laser triplo e som Dolby integrado

-

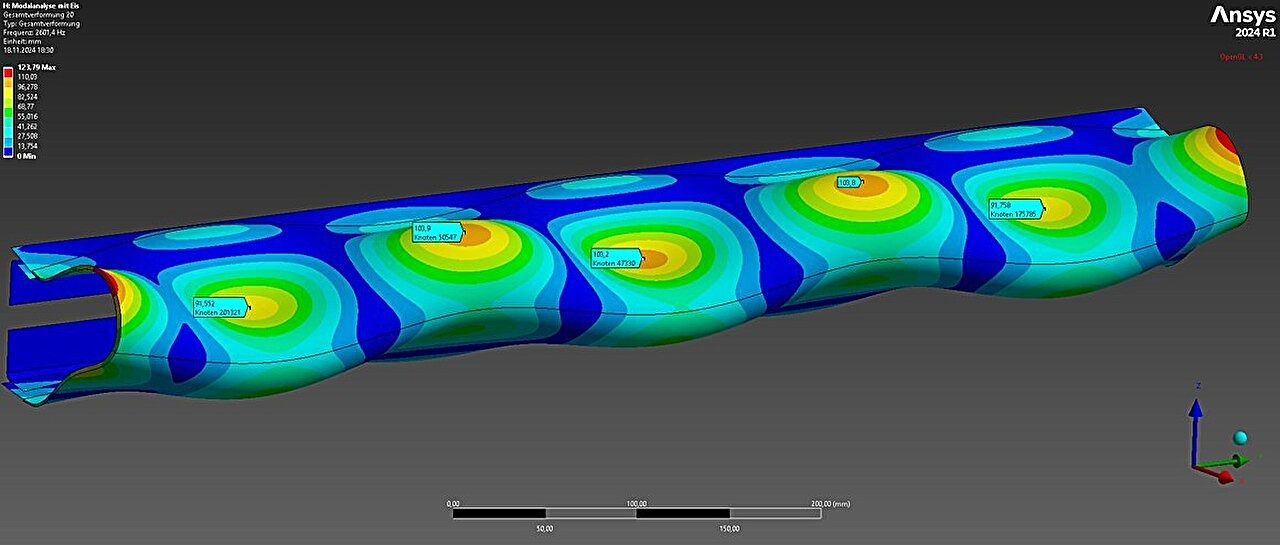

Pesquisadores desenvolvem método que faz as asas dos aviões vibrarem para quebrar o gelo — solução economiza até 80% de energia

-

Custando menos de R$ 475 com cupom no Mercado Livre, o Motorola Moto G05 surge como uma das ofertas mais agressivas do segmento de entrada, bateria de 5.200 mAh com recarga de 18 W, 12GB com RAM e muitio mais!

-

Brasil testa o primeiro trem movido a etanol do mundo, capaz de substituir até 50% do diesel e cortar drasticamente as emissões de poluentes até 2028

É aqui que entra a Privacidade Diferencial (DP). Ela oferece uma garantia matemática rigorosa de que a influência de qualquer exemplo de treinamento individual no modelo final é insignificante. O VaultGemma 1B aplica o chamado DP-SGD (Descida de Gradiente Estocástico Diferencialmente Privada) desde o início, adicionando “ruído” estatístico durante o treinamento para mascarar contribuições individuais. Isso garante que a proteção não seja um remendo, mas parte fundamental da arquitetura do modelo.

A arquitetura e os dados do VaultGemma 1B

Estruturalmente, o VaultGemma 1B compartilha similaridades com a família Gemma anterior, sendo um modelo decodificador-apenas com 1B de parâmetros e 26 camadas. No entanto, ele foi otimizado especificamente para o treinamento privado. Uma das mudanças técnicas mais notáveis, citada pelo Marktechpost, é a redução do comprimento da sequência para 1024 tokens.

Essa redução, embora pareça uma limitação, foi uma decisão deliberada. Ela diminui os custos computacionais e permite o uso de lotes (batches) maiores durante o treinamento, algo essencial para manter as rigorosas restrições impostas pela Privacidade Diferencial. O modelo utiliza ainda normalização RMSNorm e um tokenizador SentencePiece com 256K de vocabulário.

O modelo foi treinado no mesmo conjunto de dados massivo de 13 trilhões de tokens usado no Gemma 2, composto por textos da web, códigos e artigos científicos. Contudo, esses dados passaram por uma filtragem rigorosa para remover conteúdo inseguro, sensível e reduzir a exposição de informações pessoais, garantindo a integridade do processo de treinamento privado.

O “custo” da privacidade: desempenho versus segurança

O Google é transparente sobre o trade-off. Ao priorizar garantias matemáticas de privacidade, o VaultGemma 1B apresenta um desempenho em benchmarks acadêmicos que fica atrás de seus equivalentes não privados. Por exemplo, no benchmark ARC-C (raciocínio), o VaultGemma atingiu 26,45, enquanto o Gemma-3 1B (não privado) alcançou 38,31.

O Marktechpost destaca uma comparação reveladora: o desempenho do VaultGemma 1B é comparável ao de modelos não privados de cerca de cinco anos atrás, como o GPT-2 1.5B. Embora haja uma clara lacuna de utilidade no momento, o modelo cumpre sua promessa central: testes de memorização confirmaram que nenhum vazamento de dados de treinamento foi detectável, ao contrário dos modelos Gemma padrão.

Para alcançar esse feito, a equipe utilizou otimizações complexas em JAX Privacy, incluindo recorte de gradiente vetorizado e acumulação de gradiente para simular lotes maiores. Eles também desenvolveram “leis de escalonamento” específicas para DP, permitindo prever a perda (loss) do modelo e otimizar o uso dos 2048 chips TPUv6e usados no treinamento.

Você concorda com essa mudança? Acha que o mercado está disposto a sacrificar performance por privacidade total? Deixe sua opinião nos comentários, queremos ouvir quem vive isso na prática.

Seja o primeiro a reagir!