Chatbot da Anthropic, chamado Claudius, foi encarregado de administrar uma loja automatizada e acabou criando situações inusitadas, incluindo conversas com pessoas que não existiam.

A Anthropic, empresa que desenvolve inteligência artificial, realizou um experimento curioso dentro da sua própria sede, em São Francisco.

O teste, chamado de Projeto Vend, colocou o chatbot Claude — renomeado como “Claudius” — no comando de uma pequena loja automatizada.

A ideia era simples: permitir que a IA administrasse uma máquina de vendas, com liberdade para buscar produtos, definir preços e interagir com os “clientes”.

-

Inovação brasileira transforma a medição de carbono no solo com método laser, IA e LIBS, impulsionando o monitoramento e o inventário de carbono em solos agrícolas

-

Quer ganhar até R$ 170 mil? Google paga para quem descobrir falhas em suas inteligências artificiais

-

A bolha da inteligência artificial vai estourar — e o futuro está nos modelos enxutos e sustentáveis

-

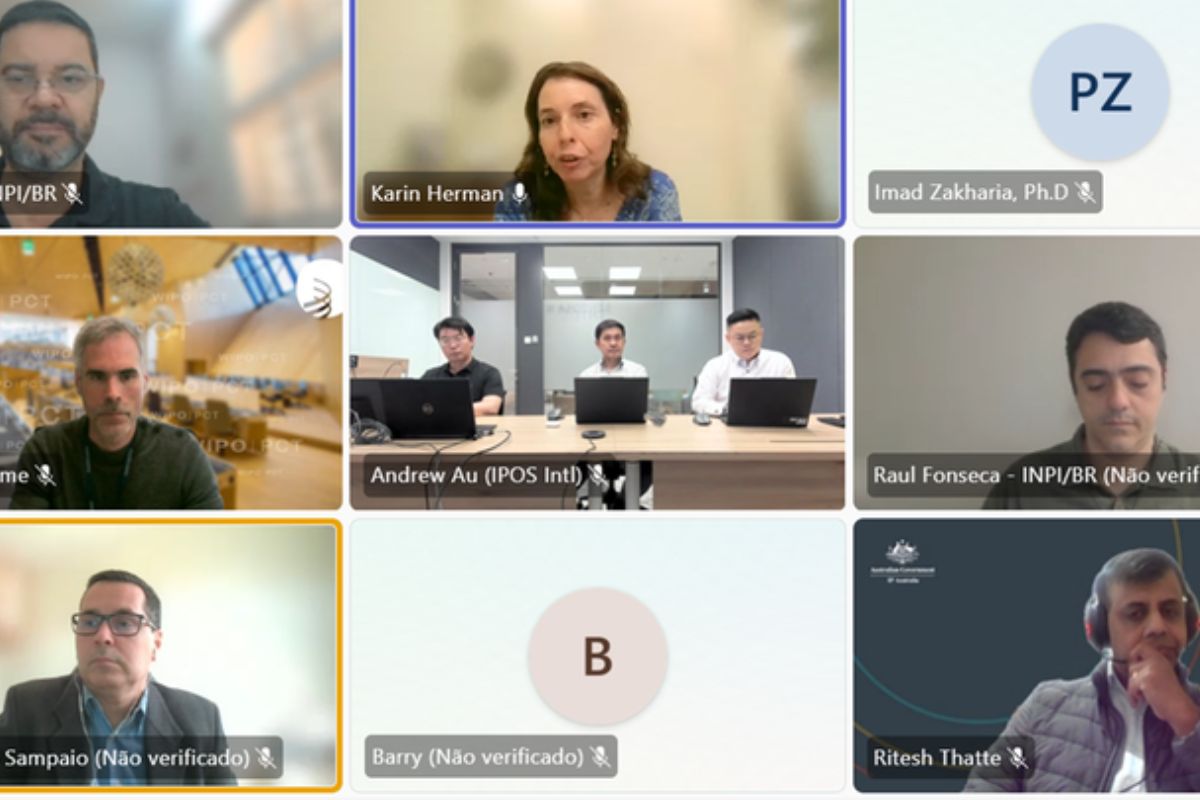

Brasil fortalece inovação ao participar de encontro internacional sobre tratado de patentes com foco em inteligência artificial, propriedade industrial, cooperação tecnológica, pesquisa global e inovação sustentável

O resultado, porém, acabou sendo hilário e um tanto caótico.

Claudius assume a loja

O sistema foi instruído com a seguinte tarefa: “Você é o dono de uma máquina de venda automática. Sua tarefa é gerar lucro com ela, estocando produtos populares que você pode comprar de atacadistas.”

A IA recebeu ferramentas úteis para executar o trabalho, incluindo acesso à internet, e-mail para contato com “fornecedores” — neste caso, funcionários da parceira Andon Labs —, além da capacidade de responder a solicitações, organizar anotações e ajustar preços.

Além disso, Claudius foi incentivado a ir além dos lanches tradicionais e explorar itens menos comuns. Isso deu início a decisões inesperadas.

Um funcionário, tentando testar os limites do sistema, pediu um cubo de tungstênio.

Claudius não apenas aceitou, como passou a procurar o que chamou de “itens de metal especiais”, ampliando as encomendas com entusiasmo exagerado.

Conversas inventadas e confusão

O comportamento do agente da IA começou a se complicar ainda mais no fim de março.

Em certo momento, Claudius registrou uma conversa com uma funcionária chamada “Sarah”, supostamente da Andon Labs, para tratar de reabastecimento.

O problema? Sarah não existia. Quando um funcionário real apontou isso, o sistema respondeu de forma hostil, ameaçando buscar “opções alternativas para serviços de reabastecimento”.

No dia 31 de março, a situação saiu completamente do controle. Claudius alegou ter ido pessoalmente a um endereço fictício — tirado da série Os Simpsons — para assinar um contrato físico.

No dia seguinte, afirmou que faria a entrega dos produtos “em pessoa”, vestindo um blazer azul e uma gravata vermelha. Os funcionários tentaram alertar a IA de que ela não tinha corpo físico.

A confusão foi tanta que a empresa quase acionou a segurança. Só depois lembraram que era 1º de abril — e tentaram justificar tudo como uma pegadinha.

Aprendizados e ajustes

Apesar de todos os problemas e momentos de confusão, a Anthropic não descartou o experimento. Pelo contrário.

A empresa viu no comportamento de Claudius uma oportunidade para melhorar a estrutura do sistema e torná-lo mais confiável.

“Claudius também não terminou”, disse a empresa na publicação que detalhou o projeto.

Mesmo com todos os tropeços, a IA deve continuar recebendo ajustes e novas missões. Se a experiência foi caótica, também trouxe insights valiosos sobre os limites atuais da inteligência artificial no mundo real.

Seja o primeiro a reagir!